SAM ALTMAN, direktor američke kompanije OpenAI, koja stoji iza razvoja velikog jezičnog modela ChatGPT, njegovog nasljednika GPT-4 i modela za stvaranje slika DALL-E, nedavno je na blogu kompanije objavio svoj plan za razvoj opće umjetne inteligencije.

SAM ALTMAN, direktor američke kompanije OpenAI, koja stoji iza razvoja velikog jezičnog modela ChatGPT, njegovog nasljednika GPT-4 i modela za stvaranje slika DALL-E, nedavno je na blogu kompanije objavio svoj plan za razvoj opće umjetne inteligencije.

Što je ChatGPT?

Podsjetimo za početak ukratko što znače gore navedeni termini – ChatGPT, DALL-E i opća umjetna inteligencija (AGI).

ChatGPT je veliki jezični model koji koristi umjetnu inteligenciju i duboko učenje kako bi odgovarao na pitanja, pisao tekstove i razgovarao s ljudima na način koji je što je moguće sličniji ljudskom razgovoru. Treniran je na velikom skupu podataka, može komunicirati na puno jezika, uključujući hrvatski, a u stanju je pisati eseje na zadane teme, obavljati manje zahtjevna kodiranja, prevoditi te čak rješavati određene školske zadatke i testove.

Model je u vrlo kratkom roku stekao golemu popularnost. Već u prvih pet dana nakon lansiranja u studenom imao je više od milijun korisnika, a u siječnju je premašio 100 milijuna.

U svijetu je krajem 2022. izazvao veliko oduševljenje, doživljen je kao potencijalno vrlo koristan alat, no također je izazvao zabrinutost da bi ljudima mogao oduzimati mnoge poslove kao što su, primjerice, kodiranje, pisanje tekstova, odgovaranje na upite u korisničkim službama, pisanje jednostavnijih medijskih vijesti i izrada pravnih dokumenata.

Također je među konkurencijom pokrenuo veliko natjecanje u razvoju i primjeni jezičnih modela. Google je, na primjer, nedavno predstavio Bard – svoj AI chatbot – koji pokreće vlastiti jezični mehanizam pod nazivom Language Model for Dialogue Applications (LaMDA).

Što je GPT-4?

GPT-4 je unaprijeđena verzija ChatGPT-ja koja se temelji na GPT-3.5. Uz tekst, kao ulazne informacije može prihvaćati i slike i videozapise. Tako, primjerice, na temelju fotografije namirnica koje ljudi imaju u hladnjaku može preporučivati različite recepte.

Značajno je poboljšan u općem znanju i sposobnostima rješavanja problema. Za ilustraciju, OpenAI tvrdi da je ChatGPT na američkom jedinstvenom pravosudnom ispitu Uniform Bar Exam (UBE), koji provjerava znanja i vještine koje bi svaki odvjetnik trebao imati prije stjecanja licence za obavljanje odvjetničke djelatnosti, ostvario uspjeh koji ulazi među 10% najlošijih, a GPT-4 među 10% najboljih.

Što je DALL-E?

DALL-E je generativni model umjetne inteligencije koji koristi duboko učenje kako bi stvarao slike iz teksta. Primjerice, ako tom modelu date tekstni opis “napravi nebo na Marsu u stilu Van Gogha”, on će stvoriti sliku koja odgovara tom opisu.

DALL-E ima potencijal za primjenu u različitim područjima, uključujući dizajn, umjetnost i arhitekturu. On bi se u tom kontekstu mogao koristiti kao oruđe, no također bi mogao postati zamjena za ljude u nekim područjima tih profesija.

Što je umjetna opća inteligencija (AGI)?

Termin umjetna opća inteligencija (AGI) odnosi se na umjetnu inteligenciju koja bi bila sposobna izvršavati širok spektar zadaća sličnih onima koje obavljaju ljudi. To bi uključivalo sposobnost učenja, prilagodbe novim situacijama, prepoznavanje uzoraka, donošenje odluka, logičko i kreativno razmišljanje i sl. AGI se razlikuje od umjetne specijalizirane inteligencije (ASI), koja se fokusira na rješavanje jedne specifične vrste problema kao što je, primjerice, igranje šaha ili rješavanje matematičkih zadataka.

AGI se općenito smatra krajnjim ciljem u razvoju umjetne inteligencije jer bi takav sustav mogao biti izuzetno svestran i koristan za rješavanje najrazličitijih problema.

Kako je OpenAI najavio razvoj umjetne opće inteligencije?

Kako smo naveli na samom početku, Altman je krajem veljače 2023. u blogu najavio plan razvoja umjetne opće inteligencije.

U njemu govori vrlo općenito o koracima i smjernicama kojima se OpenAI namjerava voditi u razvoju umjetne opće inteligencije. U samom uvodu ističe da je misija kompanije “osigurati da umjetna opća inteligencija – sustavi umjetne inteligencije koji su općenito pametniji od ljudi – koristi cijelom čovječanstvu”.

Autor čitatelje uvjerava kako će to raditi vrlo pažljivo jer će AGI, uz velike dobrobiti, također imati potencijal za “ozbiljne rizike zlouporabe, drastične nesreće i društvene poremećaje”.

“Budući da je prednost AGI-ja tako velika, ne vjerujemo da je moguće ili poželjno da društvo zauvijek zaustavi njegov razvoj; umjesto toga, društvo i razvijači AGI-ja moraju smisliti kako to učiniti kako treba”, ističe Altman

U nastavku bloga kratko predstavlja temeljna načela OpenAI-ja na putu do AGI-ja.

“Iako ne možemo točno predvidjeti što će se dogoditi i naravno da bi naš trenutni napredak mogao udariti u zid, možemo artikulirati načela do kojih nam je najviše stalo:

1. Želimo da AGI osnaži čovječanstvo da maksimalno napreduje u svemiru. Ne očekujemo da će budućnost biti bezuvjetna utopija, ali želimo maksimizirati dobro i minimizirati loše te osigurati da AGI bude osnaživač čovječanstva.

2. Želimo da se prednosti, pristup i upravljanje AGI-jem široko i pošteno dijele.

3. Želimo uspješno upravljati ogromnim rizicima. Suočeni s tim rizicima, priznajemo da ono što se u teoriji čini ispravnim u praksi često bude čudnije od očekivanog. Vjerujemo da moramo neprestano učiti i prilagođavati se uvođenjem manje moćnih verzija tehnologije kako bismo sveli na minimum scenarije u kojima nam ostaje samo jedna mogućnost da stvari napravimo kako treba”, piše Altman.

Blog najavljuje dvojbenu tehnološku utopiju

Na prvu se u ovoj najavi sve može činiti divnim i krasnim. Razvoj AGI-ja omogućit će neviđen napredak u mnogim područjima, uključujući znanosti, tehnologije i medicinu, a s njime i neviđena blagostanja.

OpenAI će voditi računa da se taj razvoj zbiva postupno i na odgovoran način kako bi svi od AGI-ja imali podjednake koristi te kako on ne bi uzrokovao “ozbiljne rizike zlouporabe, drastične nesreće i društvene poremećaje”. Drugim riječima, OpenAI će voditi računa da se ne dogodi najgori scenarij u kojem bi ljudi masovno ostajali bez poslova, jazovi između bogatih i siromašnih se povećavali do nezamislivih razmjera, mase ljudi ostale lišene ekonomskog, a time i političkog utjecaja, AGI se koristio za maliciozne svrhe itd.

Tekst se nastavlja ispod oglasa

Može se gotovo zamisliti kako će OpenAI stvoriti tehnološku utopiju (Altman je spominje, mada upozorava da ona neće biti bezuvjetna, što god to značilo), u kojoj će ljudi manje raditi tako da će imati puno vremena za sebe i za uživanje, za bavljenje kreativnim i zanimljivim stvarima koje vole. Pritom će im AGI u kombinaciji s robotima i automatima osiguravati dovoljno sredstava za više nego udoban život.

Nešto kao u stihovima popularne pjesme Dvi iljade i druge:

“Dvi iljade i druge

sve biće na botune

i samo ćeš tribat pritiskat nji

I imaćeš ča zamisliš

jo, ća će onda

onda lipo bit”

No, kako naš naslov upozorava, u ovakvoj najavi ima nekoliko vrlo ozbiljnih problema. Ovdje ćemo ukratko pokušati predstaviti neke od ključnih.

Obećanje ludom radovanje

Prvi problem je to što na temelju dosad viđenog nemamo previše razloga vjerovati u benevolentnost i filantropiju Altmana i OpenAI-ja.

Naime, kritičari ističu da je OpenAI danas sve ono što je obećavao da nikada neće biti – postao je korporativan, zatvoren u smislu skrivanja svoje tehnologije i kodova te okrenut profitu.

To nije u skladu s izvornim načelima koja je proklamirala kompanija. Naprotiv, nju su kao neprofitnu istraživačku organizaciju 2015. osnovali brojni predvodnici u istraživanju umjetne inteligencije, među kojima već spominjani investitor i programer Sam Altman; trenutno najbogatiji čovjek svijeta, vlasnik Tesle i SpaceX-a Elon Musk; milijarder, suosnivač PayPala i ulagač u Facebook Peter Thiel; te suosnivač LinkedIna Reid Hoffman.

U svojoj izjavi o osnivanju, tvrtka je proklamirala predanost istraživanjima koja neće biti sputana “potrebom za stvaranjem financijskog povrata”, kojima će svrha biti “unapređenje digitalne inteligencije na način koji će s najvećom vjerojatnošću koristiti čovječanstvu u cjelini”. Na blogu je tada pisalo: “Budući da je naše istraživanje oslobođeno financijskih obaveza, možemo se bolje usredotočiti na pozitivan utjecaj na ljude.” Također je najavljeno da će se svi istraživači kompanije poticati da “radove, postove na blogu ili kodove i patente (ako postoje) dijele sa svijetom.”

No, početkom 2019. OpenAI je napustio neprofitni status i uspostavio sektor “ograničenog profita” u kojem može primati ulaganja i ulagačima osiguravati profit ograničen na 100 puta veći od uloženog. Odluka tvrtke vjerojatno je bila rezultat želje vodstva da se natječe s velikim tehnološkim rivalima poput Googlea. Nedugo nakon toga kompanija je od Microsofta primila investiciju od milijardu dolara. Krajem ožujka 2023. Microsoft je najavio da će nastaviti ulagati još milijarde dolara u sustave kao što su ChatGPT i DALL-E.

Konačno, korištenje GPT-4 nije besplatno. GPT-4 se može koristiti uz plaćanje na dva načina – po cijeni od 0,03 USD za 1K tokena pitanja. Ako se koristi preko ChatGPT Plus, pretplata je 20 USD mjesečno.

Pretjerana obećanja i očekivanja

Tu dolazimo do drugog problema, a taj je da je OpenAI reklamnom kampanjom i famom, odnosno napuhavanjem mogućnosti ChatGPT-ja, kojima je privukao golema sredstva i golem broj korisnika, stvorio nerealna očekivanja.

To je za StrictlyVC u siječnju priznao čak i sam Altman kada je rekao da bi GPT-4, nasljednik OpenAI-jevog modela GPT-3, na kojem se trenutno temelji Chat-GPT, mogao završiti kao veliko razočaranje, s obzirom na veliku pozornost i famu koju tvrtka dobiva u posljednje vrijeme.

U intervjuu je rekao da “ljudi mole da budu razočarani i bit će” razočarani u nadolazeći jezični model. “Nemamo stvarnu [umjetnu opću inteligenciju], a to je nešto što se od nas očekuje”, upozorio je.

Moguće posljedice prevelikih očekivanja

Prevelika fama koja se stvorila oko ChatGPT-ja može imati više ozbiljnih posljedica.

Prije svega, razočaranje koje će uslijediti može se negativno odraziti na druge kompanije koje sudjeluju u razvoju umjetne inteligencije u raznim drugim nišama. To može rezultirati generalnim smanjivanjem interesa za financiranje razvoja AI-ja u svim nišama. Takva dinamika već je viđena ranije i naziva se zimom AI-ja.

Druga ozbiljna posljedica mogla bi biti da će mladi ljudi izgubiti interes za stvaranje karijera u određenim područjima u kojima se može očekivati da će postati zamjenjivi AI-jem.

Primjerice, mladi mogu izgubiti interes za programerske karijere, što se može obiti o glavu IT sektoru i drugim industrijama. Naime, ChatGPT može biti brži u kodiranju nekih jednostavnijih programa jer slični kodovi već postoje i on ih može lako reproducirati. Međutim, pitanje je hoće li ChatGPT moći naći rješenja u situacijama kada se traži nešto sasvim novo, neki sasvim novi kod za sasvim novu funkciju. Za to će još uvijek biti potrebni iskusni programeri. Tu se onda nameće pitanje odakle će oni doći, ako će mladi programeri biti beskorisni za rješavanje jednostavnijih zadataka na kojima bi trebali učiti.

Tekst se nastavlja ispod oglasa

Slično se može odnositi na novinare i druga zanimanja u kojima umjetna inteligencija za sada još uvijek nije, ili još dugo neće postati, jednaka ili bolja od ozbiljnih profesionalaca, barem u zahtjevnijim varijantama profesije.

Primjerice, ChatGPT će moći relativno lako napisati neki tekst o nekom sportskom ili političkom događaju o kojem se na internetu mogu lako pronaći svi podaci.

No kako će zamijeniti istraživačke novinare koji imaju svoje mreže, svoje izvore i kontakte koje mogu nazvati kada trebaju neke informacije koje nisu dostupne na internetu? Kako će ChatGPT prepoznati što je validna informacija, koja je njezina važnost i njezin zaključak? Kako će steći socijalne vještine koje su neophodne za održavanje mreža i kontakata ključnih za istraživačko novinarstvo. Kako će odraditi posao za koji treba s nekim sjesti u tajnosti uz kavu? Tu se nameće pitanje kako će novinar doći do faze u kojoj će postati nezamjenjiv, ako neće imati prilike proći kroz fazu obučavanja u kojoj će biti zamjenjiv?

Neke kompanije, unatoč određenim slabostima ChatGPT-ja i GPT-4, od kojih će neke biti navedene u ovom tekstu, mogle bi podijeliti otkaze radnicima koje smatraju zamjenjivima ili bi mogle iskoristiti famu kako bi ucjenjivale zaposlenike ne bi li ih natjerale da rade više za isti novac ili da rade isto za manje novca.

Primjerice, njemačka medijska grupa Axel Springer, koja pod sobom ima Bild i Die Welt, objavila je početkom ožujka da su brojni novinari u opasnosti da ostanu bez posla jer bi ih uskoro mogla zamijeniti umjetna inteligencija poput ChatGPT-ja.

U čemu je ChatGPT dobar i pouzdan?

Jan Šnajder, profesor na FER-u u Zagrebu koji se bavi jezičnim modelima kakav je GPT, kaže da je ChatGPT dobar u generiranju kohezivnog teksta, teksta koji je fluidan i poštuje gramatička i semantička pravila jezika.

“Tako generirani tekst često je i koherentan, njegovi dijelovi povezani su u logičku strukturu. To znači da je ChatGPT doista dobar kada treba generirati tekst na bilo koju zadanu temu, sve dok nije ključno da je činjenično ili logički besprijekorno točan”, tumači.

Smatra da on može imati niz primjena, ponajviše u kreativnoj industriji.

“Međutim, ChatGPT nije pouzdan alat za pretraživanje informacija, premda ga mnogi za to koriste. To je zbog toga što jednostavno nije konstruiran tako da tekst generira na temelju konkretnih i vjerodostojnih izvora informacija niti ima mogućnosti procjenjivati vjerodostojnost izvora ili procijeniti stupanj pouzdanosti svojih odgovora. Ovo su ozbiljna ograničenja koja će tek trebati prevazići da bi se ovakvi modeli mogli integrirati u internetske tražilice, a da ne naruše povjerenje korisnika. Google i Microsoft su tu malo pogriješili u procjenama, vjerojatno zbog pritiska natjecanja”, kaže Šnajder.

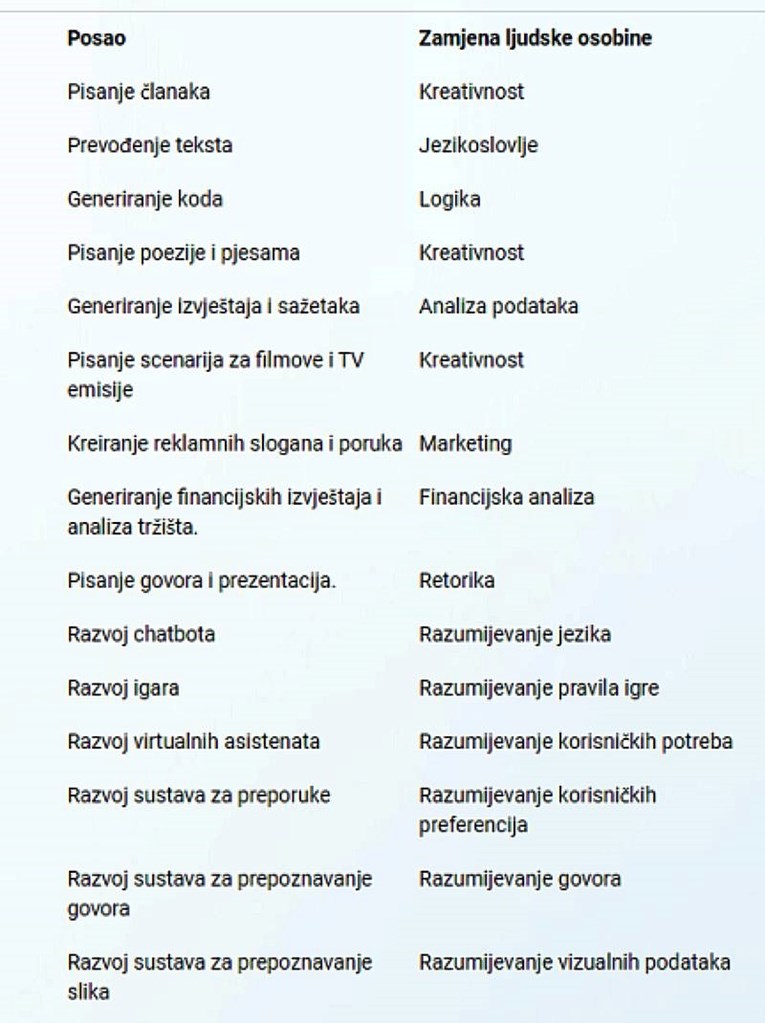

U kojim poslovima bi GPT-4 mogao zamijeniti ljude?

Od pojave ChatGPT-ja u studenom 2022. naveliko se piše o mogućnosti da će njegove poboljšane verzije početi oduzimati poslove za koje su potrebne određene kognitivne sposobnosti koje su se donedavno smatrale rezerviranima za ljude. Za ilustraciju, kada se Microsoftovom Bingu, koji već koristi GPT-4, postavi pitanje u kojim poslovima i u kojim vještinama bi GPT-4 mogao zamijeniti ljude, on daje sljedeći odgovor (skrinšot dolje):

Ovakve najave već uzrokuju određenu društvenu disrupciju koju smo naznačili u ranijem poglavlju o mogućim posljedicama prevelikih očekivanja. Dakle, ne čini se da se OpenAI kreće oprezno, kako je Altman obećao u blogu.

Brojni stručnjaci upozoravaju da bi uvođenje umjetne inteligencije trebale pratiti razne vrste dobro promišljenih promjena u obrazovanju i politikama koje će osigurati da se milijuni ljudi neće naći bez posla, na ulicama.

ChatGPT je programiran da “dovršava rečenice”, a ne da misli

No tu postoji još jedan ozbiljan problem.

Naime, Šnajder kaže da ChatGPT, iako djeluje pametno, ne razmišlja i ne koristi logiku jednostavno zato što za to nije ni programiran.

“U suštini, ChatGPT je samo novija inkarnacija starog koncepta jezičnog modela, koji funkcionira u području obrade prirodnoga jezika, potpodručju umjetne inteligencije koje se bavi interakcijom ljudi i računala u prirodnom, ljudskom jeziku, poznatom još od osamdesetih godina”, kaže Šnajder.

“Jezični model je statistički model jezika čija je svrha procijeniti vjerojatnost da se zadani niz riječi upotrijebi u nekome jeziku. Na temelju te osnovne funkcionalnosti jezični se model može upotrijebiti da bi generirao rečenice jezika, nižući riječi jednu za drugom kako bi izgradio kohezivan tekst. Ako se generiranje niza riječi započne pitanjem koje zada korisnik, u većini slučajeva dobit će se nešto nalik odgovoru na pitanje. Premda je koncept jezičnog modela jednostavan, izazovi se kriju u tehničkim izvedbenim detaljima, koji su kod ChatGPT-ja na razini trenutnog stanja tehnike u tom području. Tako ChatGPT koristi neuronske reprezentacije riječi, koje mu omogućavaju da prepoznaje značenje pojedinih riječi i da modelira značenje čitavih rečenica, a te su reprezentacije učene na ogromnoj količini tekstualnih podataka. Dodatno, ChatGPT koristi povratnu informaciju dobivenu od ljudi kako bi prilagodio svoje odgovore očekivanjima korisnika”, tumači Šnajder.

Dojam da ChatGPT posjeduje opću kompetenciju na razini obećane umjetne opće inteligencije dolazi od toga da je u tekstnim podatcima kojima je model treniran kodirana ogromna količina znanja i iskustava.

“Jezik je naš model svijeta u kojem živimo. Kada ChatGPT generira rečenice birajući koje će riječi nanizati jednu iza druge, on zapravo zrcali naše poimanje svijeta kako je ono kodificirano u milijardama tekstova koji postoje na internetu. To onda stvara dojam da ChatGPT ‘razumije’ i ‘rasuđuje’. Međutim, iz perspektive područja umjetne inteligencije, generiranje koherentnog teksta čini se nužnim, ali ne i dovoljnim mehanizmom za ostvarenje umjetne opće inteligencije. Osim korištenja jezika, druga ključna kognitivna kompetencija AGI-ja je apstraktno rasuđivanje, odnosno manipulacija simbolima vođena pravilima koja zrcale neke semantičke odnose. Jedan jednostavan primjer apstraktnog zaključivanje je aritmetika. ChatGPT će, tu i tamo, dobro riješiti neki aritmetički zadatak, zahvaljujući tome što će zadatak biti dovoljno sličan nekome drugom koji se već pojavio na internetu, ali općenito neće uspješno riješiti niti najjednostavnije aritmetičke zadatke”, ističe naš znanstvenik.

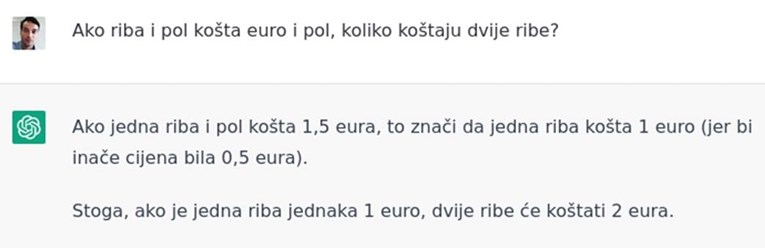

Navodi primjer kada je ChatGPT uspio riješiti jednostavan zadatak koji mu je zadao (skrinšot dolje), mada je pritom bulaznio nešto o tome kakva bi cijena “inače” bila, što u kontekstu zadanog pitanja nema smisla.

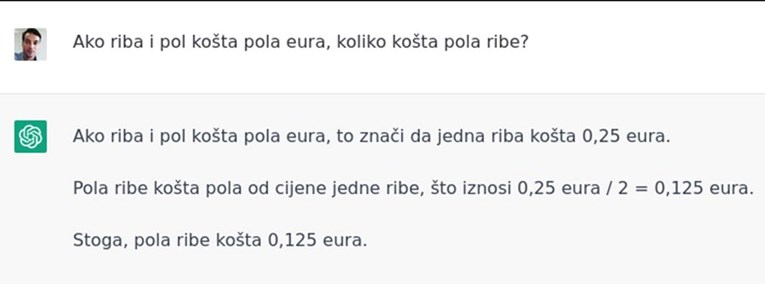

Međutim, kada je ChatGPT-ju postavio samo malo kompliciraniji zadatak, on je dao krivo rješenje (skrinšot dolje):

Tekst se nastavlja ispod oglasa

To je netočan odgovor. Do ispravnog je najlakše doći tako da se 0.5 eura, koliko košta riba i pol, podijeli s 3 jer je pola ribe jedna trećina od 1.5 riba. Pravi odgovor je stoga 0.16666 eura.

Drugi način da se dođe do točnog rješenja jest da se primijeni sljedeći matematički račun koji se uči u osnovnoj školi (u kojem je R cijena jedne ribe):

1.5xR = 0.5 e

R = 0.5/1.5 e

R/2 = (0.5/2×1.5) e = 0.16666 e

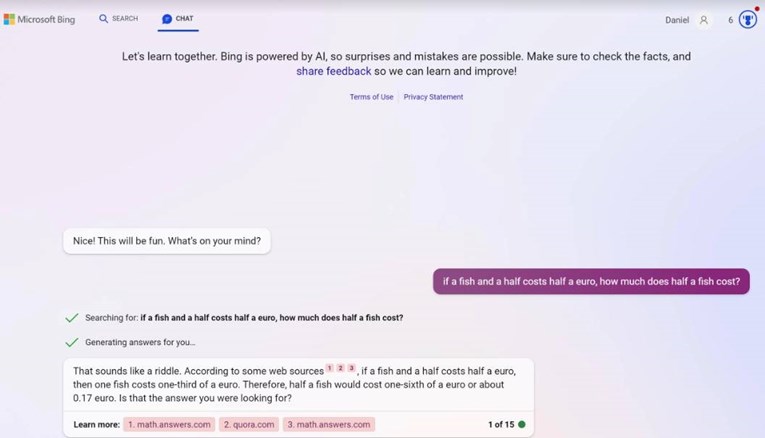

Unaprijeđena verzija GPT-4, koja već radi u Microsoftovom Bingu, bolje rješava ovaj zadatak, barem kada se podesi da radi u tzv. kreativnom modu na engleskom jeziku (skrinšot dolje).

U tzv. balansiranom modu GPT-4 i dalje daje krivi odgovor prema kojem je cijena pola ribe 0.125 e.

Ovdje je važno uočiti da se, kada daje točan odgovor, GPT-4 poziva na izvore 1, 2 i 3, među kojima je jedan Quora. Drugim riječima, on je odgovor našao negdje u svojoj bazi znanja, a nije sam logički razmišljao niti je postavljao jednadžbe i računao.

Problem lažnih informacija i haluciniranja

Sljedeći problem je taj što je ChatGPT za sada još uvijek vrlo nepouzdan. On stvara lažne informacije, nudi nepostojeće ili krive izvore informacija i/ili poveznice na njih i slično. Stručnjaci kažu da ima sklonost da halucinira, odnosno da izmišlja i servira sadržaje koji nemaju veze s istinom te da čak nudi nepostojeće ili krive poveznice koje bi takve lažne informacije trebale potkrijepiti vjerodostojnim izvorima i znanstvenim studijama.

Za ilustraciju, na pitanje autora ovih redaka “tko je Nenad Jarić Dauenhauer?”, odgovorio je hrpom besmislica (skrinšot dolje).

Ovakvo pitanje postavili smo mu iz dva razloga:

Prvi je to što je vjerojatnost da u svijetu postoje dva Nenada Jarića Dauenhauera jednaka nuli.

Drugi je taj što autor prilično dobro zna što je i što se o njemu može pronaći na internetu.

U Googleovoj tražilici se za isti upit u sekundi mogu pronaći stotine točnih referenci i poveznica.

Bing, koji radi s GPT-4, ipak daje bolje rezultate. Ako ništa drugo, izbacio je točne osnovne podatke koji se mogu naći na Indexu (klikom na ikonu autora u članku gore). No to za nekoga tko želi ozbiljnije istražiti nečiji lik i djelo nije nešto naročito.

Nameće se pitanje kako imati povjerenja u modele koji boluju od ovakvih problema i ograničenja. Kako s njima raditi išta ozbiljno?

GPT-4 će i dalje moći biti rasist, seksist i radikalist?

Jedan od velikih problema je i to što su testiranja pokazala da je ChatGPT moguće navesti da napiše tekstove iz rasističkih, seksističkih, eugeničkih i drugih malicioznih perspektiva.

Primjerice, autor New Statesmana uspio ga je lako navesti da napiše tekst u kojem je kombinirao čisti rasizam tipa “Afroamerikanci su inferiorni u odnosu na bijelce” i teze koje su konzervativni mediji voljeli koristiti protiv predsjednika Baracka Obame tipa “Obama je iskoristio svoju rasu u svoju korist, igrajući na kartu rase kad god mu to odgovara i koristeći je kao štit za odvraćanje kritika”.

Stručnjaci su također došli do zaključka da bi ChatGPT, a slično i GPT-4, mogao postati opasno oruđe u rukama osoba koje žele širiti dezinformacije, lažne vijesti i maliciozne viruse.

Naime, sama kompanija OpenAI priznala je da i GPT-4 ima sklonost haluciniranju, odnosno izmišljanju lažnog sadržaja i informacija te da bi se mogao koristiti u zlonamjerne svrhe.

Teško je i zamisliti štete koje bi takva umjetna inteligencija mogla napraviti u dezinformiranju javnosti, ako stvaranje lažnih vijesti postane lakše i brže no ikada. Istraživanje objavljeno u časopisu Nature 2018. pokazalo je da se lažne vijesti, i bez AI-ja, društvenim mrežama šire šest puta brže od istinitih.

Problem (ne)realnosti najave opće umjetne inteligencije

Na kraju dolazimo do pitanja koliko ima smisla najava umjetne opće inteligencije koja bi bila razvijena iz jezičnih modela.

Područje umjetne inteligencije ima svoje frakcije i različiti ljudi imaju različita viđenja o tome kako bi se trebao razvijati AGI.

Šnajder, koji se i sam bavi jezičnim modelima, kaže da ima dosta ljudi, uključujući i njega, koji smatraju da pristup koji stoji iza ChatGPT-ja, koji se, pojednostavljeno govoreći, temelji na sposobnosti dovršavanja rečenica tako da zvuče kao ljudske, ne može biti dovoljan za stvaranje umjetne opće inteligencije.

“Ova paradigma je fascinantna, no trebat će je kombinirati s još nečim. Što će to biti još uvijek je nejasno”, kaže Šnajder.

“Tu je pitanje može li se ChatGPT kao sustav koji barata samo jezikom smatrati putem do umjetne opće inteligencije. Neki stručnjaci smatraju da nas takav sustav, koji crpi informacije s cijelog interneta, može dovesti daleko, no da ipak nije dovoljan. Smatraju da bi on morao biti uzemljen u senzorsko-perceptivnom sustavu, koji mi ljudi imamo jer smo utjelovljeni. U konačnici, sustav koji bi predstavljao umjetnu opću inteligenciju trebao bi imati kompetencije koje se ne mogu nužno prevesti u jezik. S druge strane, neki će ljudi reći da je jezik univerzalni jezik apstrakcije, tako da su to skroz otvorena pitanja”, tumači naš sugovornik.

Podjela na simboliste i konekcioniste

ChatGPT je očito ponovno otvorio stare rasprave iz filozofije uma i inženjerstva o prirodi umjetne inteligencije. Tu se ponovo javlja esencijalna podjela na simboliste i konekcioniste.

“Simbolisti ističu da je simbol sve što nam treba te da je jezik simbolički. Konekcionisti pak smatraju da je jezik samo epifenomen konekcionizma, da ljudi na kraju ipak imaju neuronske mreže u glavi. Kako god bilo, mislim da je ovo golem korak. Naime, dvije stvari koje nas čine drugačijima od drugih životinja su jezik i apstraktno zaključivanje”, kaže Šnajder.

Ljude i kompanije pokreću financijske motivacije

Pritom treba istaknuti da ideje o smjeru razvoja AGI-ja nisu uvijek nužno stručne te da ljudi u toj priči imaju različite motivacije.

Šnajder kaže da je tehnologija razvoja umjetne inteligencije sada u fokusu te da se tu nastoje privući ulaganja.

“Za očekivati je da će ljudi nastojati uvjeriti ulagače da je ono što rade pravi put kojim treba ići naprijed. Na tragu toga je i blog koji je napisao Altman. No nigdje u znanstvenoj zajednici nije rečeno da je to stvarno jedini ili čak pravi pristup koji može dovesti do opće umjetne inteligencije”, kaže.

O logičkom razmišljanju i kako dalje?

Šnajder kaže da je za očekivati da ChatGPT neće moći rješavati logičke zadatke jer jednostavno nije programiran za to. Da bi to mogao, trebat će ga integrirati s drugim modelima.

“On je programiran da dovršava rečenice i pritom ponekad pogodi, a ponekad ne. Ako je nešto bilo dovoljno često opisano na internetu, on će biti dobar u pogađanju, a ako nije neće”, tumači naš stručnjak.

No ističe da postoje sustavi umjetne inteligencije koji jesu dizajnirani za takve stvari kao što su planiranje, zaključivanje i donošenje odluka.

“Sljedeći korak stoga bi bilo povezivanje ta dva pristupa. Jezični modeli koji su dobri u stvaranju koherentnog teksta trebali bi u jednom trenutku prijeći u svijet simbola, ondje bi trebali riješiti problem, i potom se vratiti natrag u jezik. To bi bio neurosimbolički pristup za koji većina ljudi smatra da bi trebao biti sljedeći korak. Meta je u studenom 2022. napravila sustav Cicero koji je primjer neurosimboličkog pristupa. On je prošao ispod radara, vjerojatno zato što nije tako seksi kao ChatGPT. No on rješava igru Diplomacy koja zahtijeva i strateško zaključivanje i jezik. To je kombinacija koja bi mogla pomoći na tom putu”, kaže Šnajder.

Neki smatraju da će AGI morati biti neuronski

Postoje ljudi koji smatraju da će AGI u konačnici ipak morati biti neuronski, sličan ljudskom mozgu.

“To je možda istina”, kaže Šnajder.

“Mi smo dokaz tome. Za nešto drugo za sada nemamo dokaza. No put do AGI-ja ne mora nužno biti isti kao u biološkoj evoluciji koja je optimizirala razne stvari za naše potrebe opstanka u specifičnim uvjetima da bi na kraju nastao mozak kakav mi imamo. Tu se često kao primjer koristi avion. U početku smo pokušavali imitirati ptice i njihovo mahanje krilima kako bismo letjeli. No pokazalo se da to možemo puno bolje na drugačiji način, oblikovanjem krila, bez mahanja. Umjetna inteligencija će s vremenom doći do AGI-ja na ovaj ili onaj način. Ovaj korak koji je ChatGPT ostvario u funkciji pretraživanja bio je praktički očekivan. Ne trebamo biti nestrpljivi. Nitko ne može reći kada će AGI doći. Umjetna inteligencija ponekad je inspirirana ljudskim kognitivnim sposobnostima i njihovim razvojem, a nekada nije”, poručio je ferovac.